안녕하세요

이번 글에서는 Edge Computing에 대해 설명드리려고 합니다.

1. Edge Computing 등장 배경

1-1. 클라우드 서버의 과부하

지난 AIoT 글에서 언급했던 것 처럼, "5G 기슬의 발전 + AI 기술(영상처리, 음성처리)과 접목한 IoT"로 인해 대용량 데이터들이 빠르게 클라우드 서버로 전송된다고 말씀드린바 있습니다.

https://89douner.tistory.com/243

1. AIoT란? (Feat. IoT 개발 프로세스)

안녕하세요. 이번 글에서는 제 경험을 먼저 이야기한 후, AIoT에 대해서 설명해보려고 합니다. 0. AIoT에 관심을 갖게 된 계기 제가 전기전자컴퓨터(EECS) 소속으로 석사를 할 당시에 다양한 연구실

89douner.tistory.com

기본적으로 AI 기반 모델들은 연산량이 많아 고성능 컴퓨터 기반으로 모델링 되었습니다.

그렇기 때문에, device(하드웨어: 센서 등)에서 얻은 데이터들은 클라우드에 위치한 고성능 서버 컴퓨터로 전송되고, 전송된 데이터는 해당 컴퓨터에 탑재된 AI 모델을 이용해 처리하게됩니다.

물론 Cloud에서 데이터 과부하가 발생하는 것을 막기위해 FOG라는 것을 두어, 중요한 데이터를 선별하는 변화를 꾀했지만, 이 역시 완전한 해결책은 아니었습니다. → Fog 컴퓨팅 관련링크

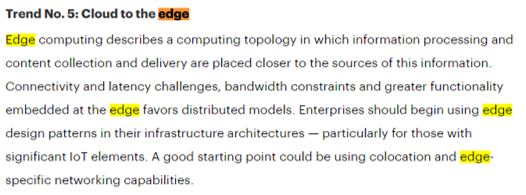

결국, 클라우드 서버에 몰리는 방대한 데이터로 인해 발생하는 트래픽 문제를 해소하기 위해 Edge Computing이라는 용어가 등장하게 됩니다.

1-2. 느린 Response time

기본적으로 데이터 양이 많으면 클라우드까지 왔다갔다 하기에 시간이 오래 걸릴 수 있습니다.

그런데, 단말기(edge)에서 AI 기법을 적용시키는 경우 고속 reponse time이 필요합니다.

예를들어, 아이의 이상행동을 감지하거나, 자율주행자동차의 경우 기기 자체에서 AI모델을 training(학습)하고 inference(추론)할 수 있게 해주어야 합니다.

2. Edge Computing 이란

위에서 언급한 것처럼, edge device 자체에서 AI모델을 training(학습)하고 inference(추론)할 수 있게 해주는 기술을 edge computing이라고 합니다.

이러한 Edge computing을 가능하게 했던건 역시 하드웨어 기술의 발달 때문이었습니다.

- 집적기술의 발달로 인한 AI chip 발전이 가능해짐

- IoT와 같은 Device에 AI chip (ex; Tegra X)이 들어갈 수 있기 때문에, 머신러닝이 가능

- 이러한 추세는 sensing과 관련된 IoT 디바이스들을 좀 더 intelligent하게 만들 수 있게 됨

- Smart phone에서는 GPU, CPU 통합 개념인 AP(Application Processor)라는 on-device가 있다.

- Qualcomm, Apple, Samsung, TSMC, NVIDIA 같은 회사들이 얽히고 얽혀 있으며, 이러한 회사들의 기술개발 트렌드를 따라가지 못하면 결국 Edge computing을 연구하려는 연구자들은 엉뚱한 연구를 할 가능성이 높아짐

(↓↓↓ 위의 회사들 간의 관계가 궁금하다면↓↓↓)

'컴퓨터 하드웨어' 카테고리의 글 목록

#Interest: World History (The past) #Work: Deep Learning (The future) #Hobby: Music, Sports

89douner.tistory.com

위와 같은 하드웨어의 발전은 더욱 Edge computing 기술을 앞당기고 decentralization을 가속화 시키고 있습니다.

이러한 Edge computing 덕분에 클라우드 뿐만 아니라 기계자체(edge or on-device)에서 AI 기술(ex; CNN)을 적용시킬 수 있게 되었습다.

또한, 딥러닝 학계에서도 고성능 PC를 기반으로 만든 딥러닝 모델을 축소시키려는 network compression 분야에 많은 노력을 기울이고 있습니다.

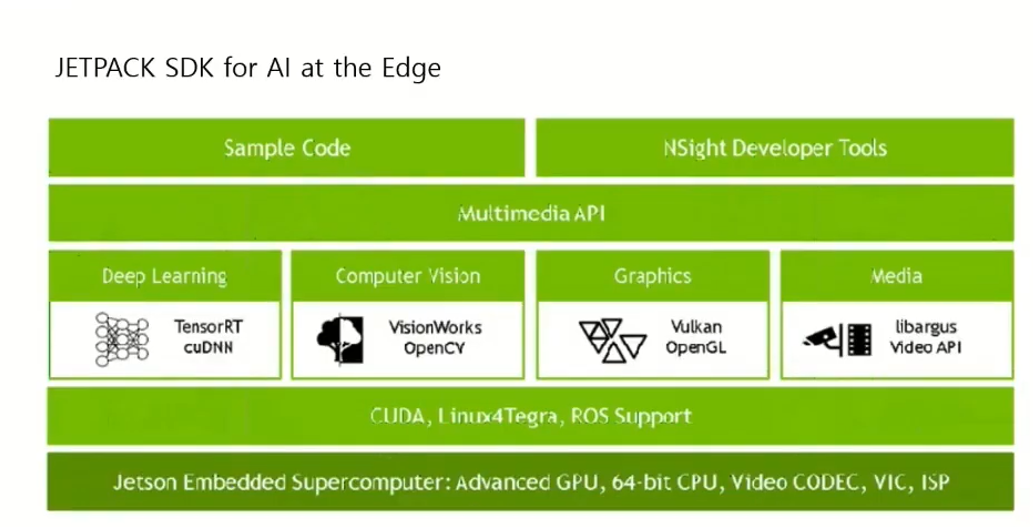

현재는 Jetson Nano와 같은 디바이스에서 딥러닝을 구현하는 edge computing 교육이 보편적으로 자리잡고 있습니다. Edge Computing API도 보기 쉽게 구성함으로써 많은 개발자들이 해당 기술을 배우는데 진입 장벽을 낮추고 있습니다.

(↓↓↓Edge computing과 Jetson Nano↓↓↓)

https://www.youtube.com/watch?v=VKufXL4FVLA

최근에는 DPU라는 개념도 등장했으니 한 번 참고해보세요!

(↓↓↓DPU↓↓↓)

https://www.youtube.com/watch?v=G-Cd50OVcyc

3. Edge Computing을 주목해야 하는

가트너(Gartner) 주식회사는 미국의 정보 기술 연구 및 자문 회사입니다.

가트너의 고객은 정부기관 및 IT 기업, 투자 회사 등 다양한데,

매해 가트너에서 전략 기술 트렌드(Gartner Top Strategic Technology Trends)를 발표할때면,

제시된 기술 트렌드를 놓치지 않기 위해 세계적인 IT 회사들이 노력을 기울입니다.

가트너는 2018, 2019, 2020 3년 연속으로 Edge Computing을 주요 키워드로 뽑을 정도로 중요한 기술이라고 주장했습니다.

때문에 많은 IT 기업들이 edge computing을 주목하고, edge computing으로 인해 파생될 효과들을 선점하기 위해 지속해서 주목 할거라 생각합니다.

'Network Compression for AI' 카테고리의 다른 글

| 3. Network Compression 기술 (0) | 2021.06.04 |

|---|---|

| 1. AIoT란? (Feat. IoT 개발 프로세스) (0) | 2021.06.04 |

| 이 글을 쓰게 된이유 (0) | 2021.06.04 |