안녕하세요.

이번 글에서는 의료 영상(Medical imaging)에서 사용하는 DICOM 파일이 어떻게 생겨났는지, 어떻게 이용되고 있는지 알아보도록 하겠습니다.

또한 DICOM이라는 것이 digital image이기 때문에, 기본적으로 digital image가 어떻게 습득이 되는지에 대해서도 알아보도록 하겠습니다.

1. 기존 딥러닝 분야에서의 이미지 데이터 format

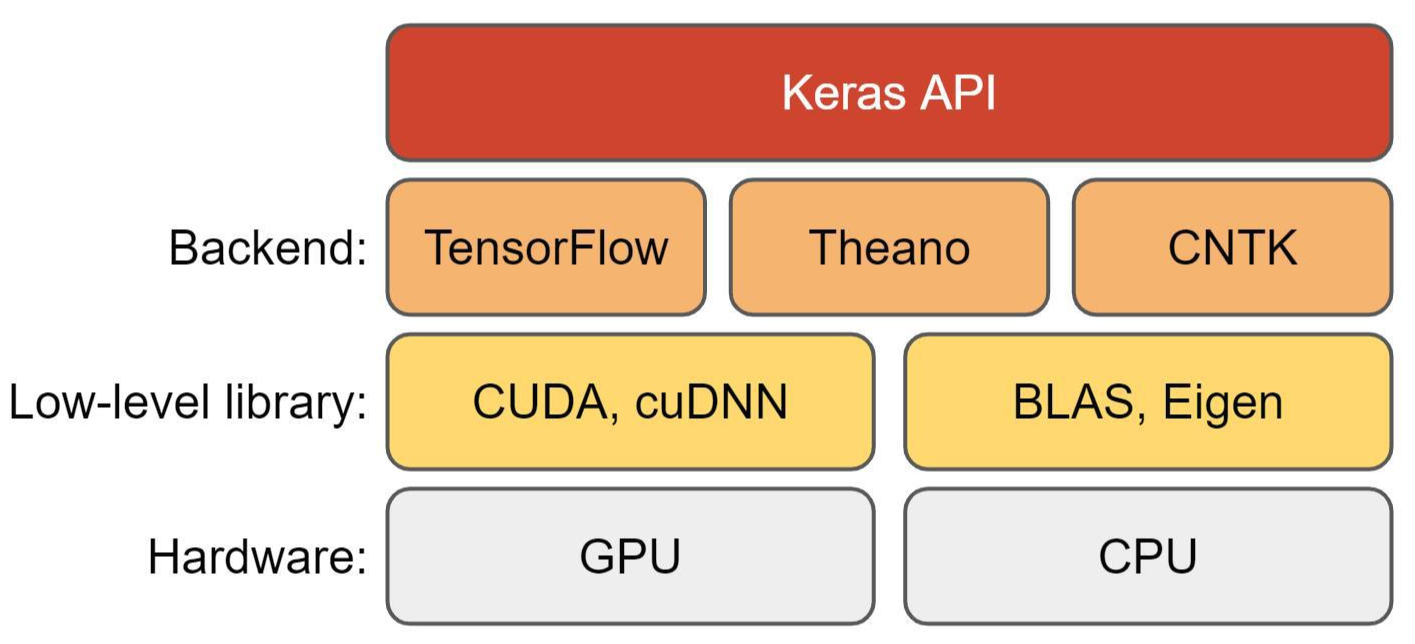

보통 딥러닝에서 이미지를 다룰 때, 보통 한 픽셀에 0~255의 pixel value를 갖는 파일형식(ex: jpg, png 등)을 이용합니다.

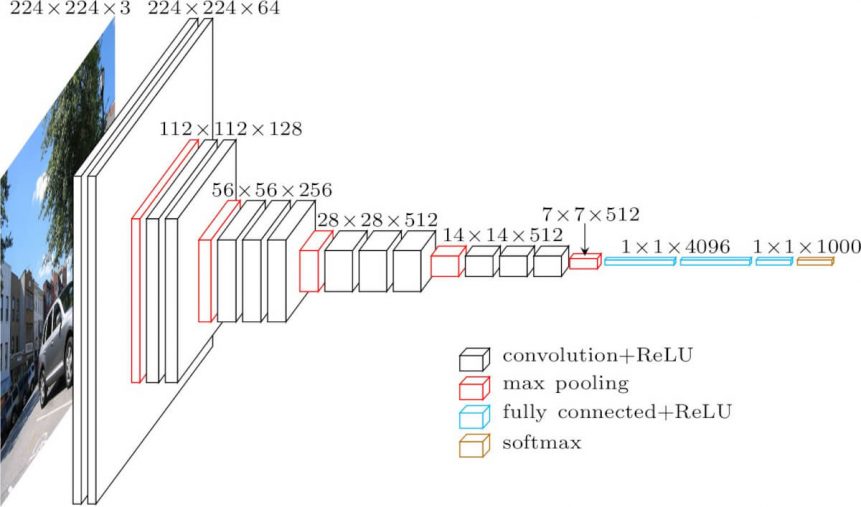

또한, 우리가 알고 있는 딥러닝 CNN 논문들을 보면 224×224 또는 448×448 같이 이미지 크기를 표준으로 하고 있다는 것을 볼 수 있습니다.

물론 최근에는 GAP(Global Average Pooling) 덕에 입력 사이즈를 제한하고 있진 않지만, 보통 1000×1000을 넘는 test를 하진 않죠. 왜냐하면, 1000×1000 크기의 이미지는 학습시키기 어려울 수 있기 때문입니다.

예를들어, 이미 1000×1000×3 이미지 자체만으로도 엄청난 대용량인데, 이러한 큰 사이즈의 이미지를 학습시키려면 딥러닝 모델이 좀 더 deeper해져야 좋은 결과를 얻을 수 있거라 생각됩니다 (물론 아닐 수 도 있습니다). 이처럼 이미지 크기에 비례해서 딥러닝 크기도 커지는 것이 일반적이기 때문에, GPU memory가 "딥러닝 모델용량+한 장의 대용량 이미지"을 감당할 수 없게 됩니다.

만약, 운 좋게 한 장의 이미지 정도는 감당할 수 있다고 하더라도, 8개 이상의 batch를 잡아주고 학습시키는 건 불가능하겠죠. 물론 이 부분도 분산처리 학습 (ex: horovod) 같은 방법을 이용하면 어느정도 해결할 수 있지만, 여전히 batch size를 크게 설정할 수 없기 때문에 딥러닝 모델을 학습시키는데 여러 불안요소를 가져갈 수 밖에 없습니다.

하지만, DICOM format의 의료 영상이미지들은 한 장에 엄청난 용량을 차지하고 있습니다. 3000×3000 resolution을 사용하는 경우도 있죠. 만약, 이러한 DICOM 데이터들의 이미지 크기를 기존 딥러닝에서 사용하는 이미지 크기(ex: 224×224) 만큼 줄여버린다면 굉장한 이미지 정보의 손실이 있을 수 있습니다. 그렇기 때문에 DICOM에서 제공하는 resolution에 기반한 딥러닝 모델 연구가 또 필요한 것이죠.

DICOM은 이미지 정보외에 다양한 메타 데이터들을 담고 있습니다. 이러한 메타 데이터에는 나이나 성별 등이 포함이 되는데, 실제로 의료 영역에서 성별과 나이는 굉장히 중요한 정보입니다.

예를 들어, 어떠한 Chest X-ray를 볼 때도 나이, 성별에 따라 진단방식이 달라질 수 있습니다. Chest X-ray에서 어떠한 소견이 있을 때, 나이가 있으신 분이라면 일반적인 현상이라고 해석할 수 있는 반면에 해당 소견이 젊은 사람에게 발생한거라면 조금 문제가 있다고 판별할 수 있습니다.

이러한 메타 데이터와 의료 이미지 데이터를 잘 이용하면 multimodal 딥러닝 모델도 만들 수 있게 됩니다.

결국 의료 영상(medical imaging) 분야에서 딥러닝 모델을 만들기 위해 알아야할 가장 기본이 되는 데이터가 DICOM입니다. 그럼 지금부터 DICOM에 대한 정의와 기원부터 알아보도록 하겠습니다.

2. DICOM (Digital Imaging and COmmunication in Medicine)의 정의와 기원

전기전자를 다루는 분야(IEEE)에서도 여러 표준규약들이 있습니다. 예를 들어, USB 같은 경우도 출시하는 회사마다 규격이 다 다르면 사용자들 입장에서 제품 중 어떤 제품을 사용 할지 혼란이 올거에요. 그래서 보통 국제단체(ex: IEEE)에서는 범용적으로 많이 쓰일 것 같은 제품에 사용되는 기술들에 한해 표준(protocol)을 만들어 이를 따르도록 합니다.

위와 같은 이유로 의료분야 또한 수 많은 표준들이 존재합니다. DICOM은 의료분야에서 사용되는 수 많은 표준 중 하나인데, 의료용 기기에서 디지털 영상자료를 표현하거나 디지털 영상자료을 이용해 통신할 때 (→디지털 영상자료를 주고 받을 때) 지켜야할 표준이라고 보시면 됩니다.

"의료용 디지털 영상 및 통신(Digital Imaging and Communications in Medicine, DICOM) 표준은 의료용 기기에서 디지털 영상표현과 통신에 사용되는 여러 가지 표준을 총칭하는 말"

그렇다면, DICOM 표준은 어떻게 해서 만들어 졌을까요?

간략하게 DICOM 표준을 만들기 위해 어떤 단체들이 참여했는지 알아보도록 하겠습니다.

1) 1983: ACR(American College of Radiology; 미국 방사선 학회)&NEMA(National Electrical Manufacturers Association; 미국 전기 공업회)에서 ACR-NEMA 디지털 영상전송 표준 위원회를 발족

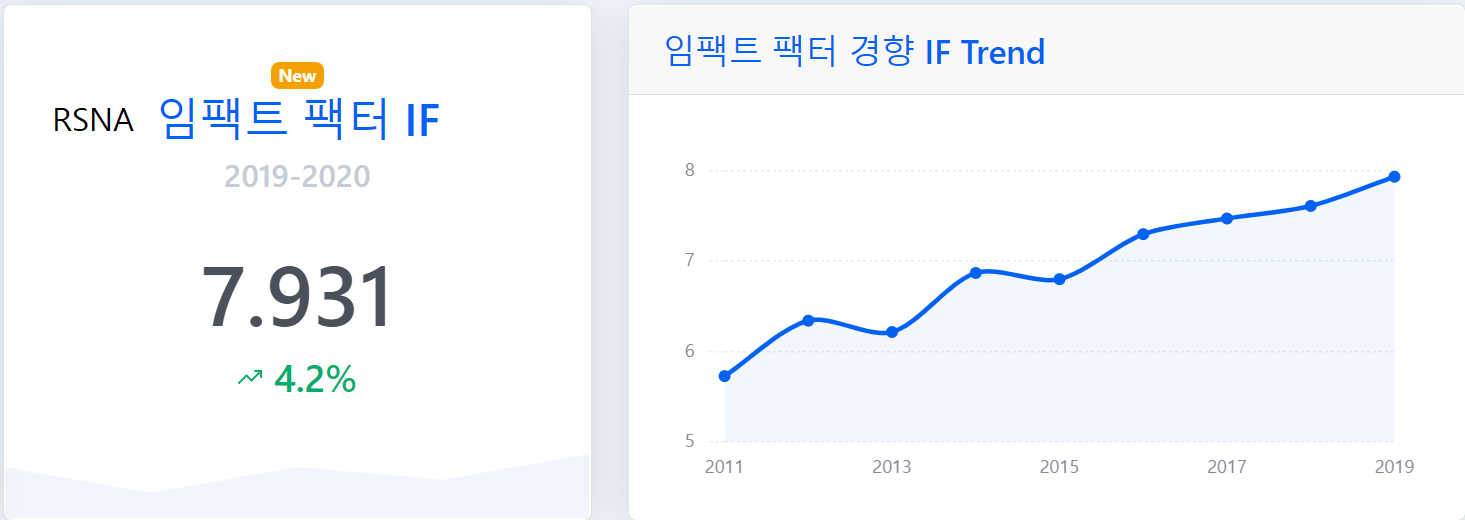

- ACR 역시 journal이 있으며 딥러닝 관련된 논문들이 많이 쏟아져 나오고 있습니다.

Journal of the American College of Radiology Increases Impact Factor in New Rankings

www.acr.org

2) 1985: ACR-NEMA 표준 버전 1.0이 RSNA(Radiological Society of North America; 북미방사선학회)에서 처음으로 발표

- 방사선이라는 것이 굉장히 다양한 분야를 다루기 때문에, RSNA에서는 아래와 같이 세부적으로 분야를 나누어 관리하고 있습니다.

RSNA Publications Online | Home

Librarians, take advantage of our free online trial offers for any of our journals. Learn more >>

pubs.rsna.org

3) 1988: ACR-NEMA 표준 버전 2.0이 RSNA에서 발표

4) 1992: RSNA 회의에서 DICOM 명칭의 표준이 제안

5) 1993: DICOM 첫 데모 버전이 발표

3. PACS (Picture Archiving and Communication System)

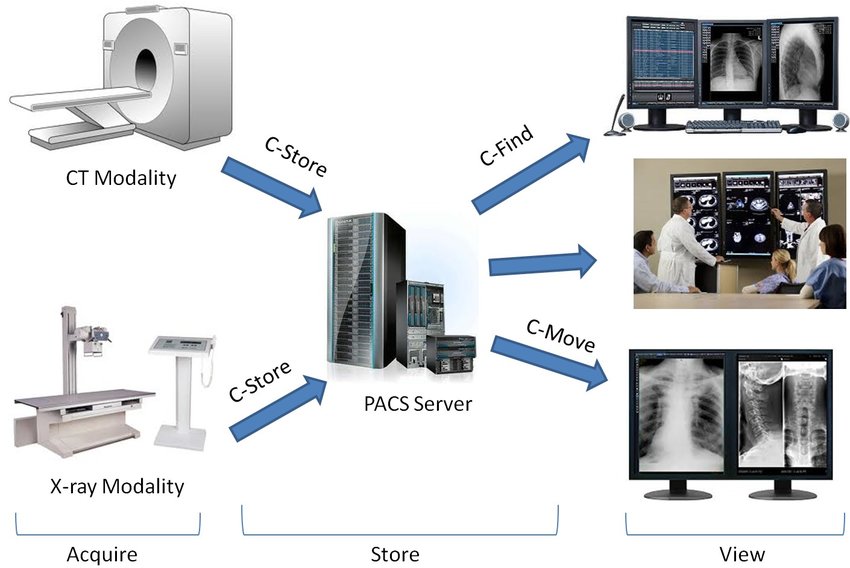

앞서 언급했듯이 DICOM은 기본적으로 디지털 영상 자료입니다. 그렇다면 이러한 디지털 자료들은 네트워크 통신을 통해 서로 주고 받을 수 도 있겠죠?

병원에서는 디지털 의료영상 이미지(Chest X-ray, CT, MRI) 같은 것을 촬영하게 되면 병원의 PACS 서버로 전송되고, 의사들이 client system을 이용해서 영상을 판독하게 됩니다.

PACS는 디지털 의료영상이미지를 DICOM이라는 국제표준규약에 맞게 저장,가공,전송하는 시스템입니다.

X-ray, CT, MRI 같은 디지털 의료영상 (digital medical imaging) 장비를 사용하여 획득된 의료영상이미지는 DICOM형식으로 저장되게 되며 판독결과와 진료기록이 추가될 수 있습니다. 또한 네트워크를 통해서 병원 내, 외의 단말로 전송이 가능합니다.

4. Digital image 습득

앞서 정의한 DICOM에 대해서 다시 한 번 살펴보도록 하겠습니다.

"의료용 디지털 영상 및 통신(Digital Imaging and Communications in Medicine, DICOM) 표준은 의료용 기기에서 디지털 영상표현과 통신에 사용되는 여러 가지 표준을 총칭하는 말"

결국, 의료용 디지털 영상이라는 것도 기본적으로 digital image이기 때문에, digital image가 어떻게 습득되는지를 알고 있어야 합니다.

그럼 지금부터 디지털 이미지가 어떻게 얻어 지는지 알아보도록 하겠습니다.

1) Source

어떠한 object(객체)를 이미지로 표현해주기 위해 가장 먼저 요구되는 요소가 energy source 입니다. 예를 들어, 우리가 카메라로 어떤 물체를 찍는 것은 빛(light source)에 반사되는 객체를 capture하는 것과 같습니다.

의료 영상(medical imaging)에서도 특정 객체를 디지털 이미지로 표현하기 위해서는 energy source가 필요한데, 방사선을 사용할 경우 X-ray, CT, PET 영상 이미지를 얻을 수 있고, 자기장을 이용하면 MRI 영상 이미지를 얻을 수 있습니다.

(↓↓↓X-ray, CT 이미지에 대한 설명 ↓↓↓)

https://89douner.tistory.com/257?category=991951

2-1. 2D 영상의료(medical imaging) 이미지란? (Feat. X-ray, CT, 전처리)

안녕하세요. 이번 글에서는 2D 이미지로 사용되는 대표적인 영상이미지인 X-ray와 CT에 대해서 알아보도록 하겠습니다. 먼저, X-ray, CT에 대해 간단히 알아본 후, 2D 영상 이미지에서 사용되는 전처

89douner.tistory.com

(↓↓↓MRI PET에 대한 설명 ↓↓↓)

https://89douner.tistory.com/258?category=991951

2-2. 2D 영상의료(medical imaging) 이미지란? (Feat. MRI, PET, 초음파, 내시경 영상이미지)

안녕하세요. 이번 글에서는 MRI, PET, 초음파, 내시경 영상 이미지에 대해 알아보도록 하겠습니다. 사실 MRI, PET, 초음파, 내시경 영상 등을 딥러닝에 적용해 본적이 없기 때문에, 해당 이미지들에

89douner.tistory.com

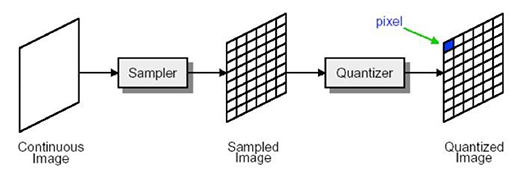

2) Sampler

특정 energy source로 부터 어떤 이미지(아래 그림의 맨 왼쪽 부분)를 획득했다고 가정해보겠습니다.

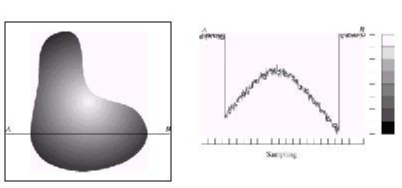

아래 그림의 맨 왼쪽 부분에 표시된 object에서 A에서 B까지 색의 변화를 표현하면 오른쪽 이미지 처럼 continous한 그래프 형태를 띄는 것을 알 수 있습니다. 이러한 continuous한 이미지를 디지털화 시켜주기 위해서 가장먼저 하는 것은 sampling 작업입니다.

[Sampling 작업]

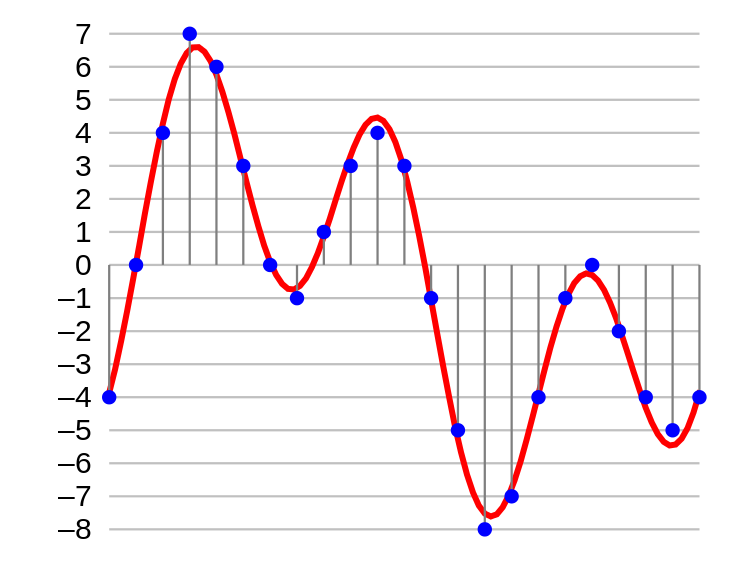

- 우선 A에서 B까지의 continous한 그래프에서 일정 간격을 두고 값들을 sampling(표본추출)을 합니다.

- sampling한 수가 결국 x축에서 discrete 범위가 됩니다.

- 예를 들어, 아래의 그림 같은 경우는 23개의 영역이 되는데, 위에서 언급한 A에서 B까지의 영역이 23개의 pixel이 존재한다는 말과 동일합니다. (보통 2D에서는 pixel로 표현되고, 3D에서는 voxel로 표현됩니다)

- 즉, sampling 과정에서 추출한 sampling 수가 digital image의 resolution을 결정한다고 볼 수 있습니다.

- 그리고 이때 sampling을 통해 생겨난 각각의 pixel들의 값(=y축)을 intensity라고 합니다.

- 여기서 중요한 것은 아직 이때의 pixel값이 우리가 흔히 알고 있는 discrete(0~255)의 범위를 갖는것이 아닌 continuous한 범위를 갖고 있다는 것을 인지해야 합니다 (아래 이미지에서는 sampling된 요소들의 값들(=파란색 points)이 discrete하게 표현되어 있으나 실제로는 sampling된 y값은 실수 값을 갖을 수 있습니다. 아래 파란색 points들은 quantization이 적용된 결과 입니다. quantization은 바로 뒤에서 설명하겠습니다.)

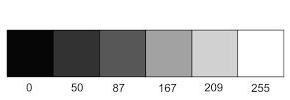

3) Quantization

앞서 언급했듯이, sampling 단계에서 얻은 intensity는 continous 특성을 갖는 실수 범위를 갖습니다. 이러한 continous한 값을 디지털화 시켜주기 위해 quantization이라는 기법이 적용됩니다.

"The continuous range of light(energy) intensity (0<x<i) received by the digital image acquisition system need to be quantized to gray level (0~255)"

우리가 흔히 알고 있는 pixel 값은 8비트 기준으로 0~255의 범위(2^8)로 표현합니다.

하지만 꼭 8bit로 표현할 필요는 없습니다. 때에 따라서는 16bit의 범위(2^16)로 표현할 수도 있고, 1bit의 범위로 표현할 수 도 있습니다. 즉, 사용되는 bit에 따라 표현하려는 색의 범위가 결정됩니다.

이때, 색의 범위를 위해 사용되는 bit 수를 bit depth라고 합니다.

표현하려는 범위가 커질 수록 bit depth 또한 커지고, 이에 따라 디테일한 색정보를 표현할 수 있습니다.

위에서 설명한 내용에서 중요한 용어들을 정리하면 아래와 같습니다.

- Resolution: Sampling 갯수=이미지 사이즈

- Intensity: Sampling point(위치: 2D→pixel, 3D→voxel)에서의 값

- Gray level: quantization → pixel값 0~255

지금까지 언급한 내용들을 하나의 이미지로 표현하면 아래와 같습니다.

지금까지 DICOM에 대한 설명과 digital image를 습득하는 과정에대해 알아보았습니다.

다음 글에서는 지금까지 배운 내용을 기반으로 DICOM file format이 어떻게 구성되어 있는지 알아보도록 하겠습니다.

[Reference]

의료용 디지털 영상 및 통신 표준 - 위키백과, 우리 모두의 백과사전

의료용 디지털 영상 및 통신(Digital Imaging and Communications in Medicine, DICOM) 표준은 의료용 기기에서 디지털 영상표현과 통신에 사용되는 여러 가지 표준을 총칭하는 말로, 미국방사선의학회(ACR)와 미

ko.wikipedia.org

https://slidesplayer.org/slide/12934045/

(Digital Imaging and COmmunictions in Medicine) -디지털정보융합학과- 홍각표 - ppt download

0. Index Introduction General DICOM Concepts DICOM Network DICOM Service Class DICOM Image SOP Instance New Feature of DICOM

slidesplayer.org

'Medical AI research > Background' 카테고리의 다른 글

| 4-1. Python으로 dicom 데이터 읽기 (Feat. pydicom, SimpleITK) (0) | 2021.07.03 |

|---|---|

| 3-2. DICOM이란? (Feat. DICOM format and Viewer) (4) | 2021.07.03 |

| 2-2. 2D 영상의료(medical imaging) 이미지란? (Feat. MRI, PET, 초음파, 내시경 영상이미지) (0) | 2021.06.12 |

| 2-1. 2D 영상의료(medical imaging) 이미지란? (Feat. X-ray, CT, 전처리) (1) | 2021.06.12 |

| 1. 의료 인공지능에서 사용하는 대표적인 지표들 (2) - Sensitivity, Specificity, ROC Curve, AUC, PPV (3) | 2021.06.10 |